|

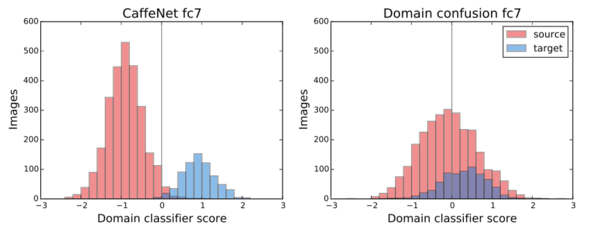

梯度反转层不会使域分类损失的错误最小化,反而使模型中的此类错误最大化。在实际操作中,这意味着该模型在学习使其最小化原始目标的表征,而不允许它区分两个域,而后者有助于知识迁移。虽然图17中显示的仅以规则目标训练的模型明显能够根据已学习的表征来分辨域,但是如果一个模型的目标增加了域混淆项,它就无法做到了。

图17:常规和域混淆模型的域分类器得分 相关研究 虽然本文是关于迁移学习的,但迁移学习不是目前机器学习中将有限的数据作为杠杆、将学到的知识用于新任务以及使模型在新环境中更好泛化的唯一办法。下面,我们来介绍一些和迁移学习目标相关或互补的其他研究方向。 半监督学习 转移学习旨在最大限度地利用目标任务或域中的未标记数据。这也是半监督学习的标准,它遵循经典的机器学习设置,但只假定有限量的标签样本进行训练。半监督学习的许多经验和见解同样适用于迁移学习。 更有效地利用现有数据 与迁移学习和半监督学习相关的另一个方向是使模型能够在有限数据的情况下更好地工作。 这可以通过几种方式完成:可以利用无监督或半监督学习从未标记的数据中提取信息,从而减少对标记样本的依赖;可以让模型访问数据中固有的其他特征,同时减少其正则化中的过度拟合;最后,可以利用到目前为止仍然被忽视的数据。 提高模型的泛化能力 提高模型的泛化能力也是一种方法。为了实现这一点,我们必须首先更好地了解大型神经网络的行为和复杂性,并调查其为什么以及如何泛化。 增加模型的鲁棒性 在改进我们模型泛化能力时,我们可能将其很好地泛化到类似的实例上,但在意外或非典型的输入上仍然出现严重错误。因此,一个关键的目标是增加我们模型的鲁棒性。近来由于对抗学习的进展,对这一方向的研究越来越多。已经有许多研究提出方法,使得模型可以在不同环境中对最坏情况或对抗性样本表现更好。 多任务学习 在迁移学习中,我们主要关心我们的目标任务。相比之下,在多任务学习中,目标是在所有任务上都表现良好。虽然多任务学习方法不能直接适用于迁移学习的设置,但有助于多任务学习的想法仍然可以使迁移学习受益。 持续学习 虽然多任务学习允许我们在许多任务中保留知识,而不会对我们的源任务造成性能损失,但只有所有任务都有训练时间,这才是可能的。对于每个新任务,我们通常需要重新调整我们所有任务的模型。 零次学习(Zero-shot learning) 最后,如果我们将迁移学习推到极限,仅仅从少数几个甚至零个样本中学习,我们就能分别得到少量、一次和零次的学习。执行一次和零次学习的模型是机器学习中最难的问题之一。这对我们人类却是自然而然的。 结论 总之,迁移学习提供了许多令人兴奋的研究方向,特别是许多需要将知识迁移到新任务并适应新领域的模型的应用。我希望能够本文能为您提供关于迁移学习的总体认识,并能激发您的兴趣。 #transferlearningmethods 新智元“3·27”AI 技术峰会购票二维码: (责任编辑:本港台直播) |