|

类似的假设也用于激发生成模型:当训练生成模型时,我们假设生成逼真图像的能力要求了解图像的底层结构,而后者又可应用于许多其他任务。这个假设本身依赖的前提是所有图像都位于低维流形,也就是说可以通过模型提取图像的一些底层结构。使用生成对抗网络生成逼真图像的最新进展表明,这种结构可能确实存在,如图15所示,模型在卧室图像空间中的点之间展示逼真过渡的能力证明了这一点。

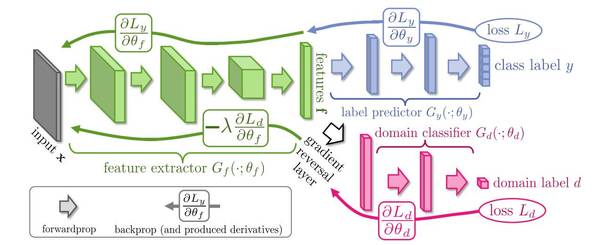

图15:走过卧室的图像流形 除了视觉任务,预先训练的特征在其他任务中是否有用? 现场生成的CNN特征在视觉任务中取得了无与伦比的成果,但使用其他类型数据(如语言)的其他领域可否复制这个成功,仍然存有疑问。目前,没有现场特征可以在NLP中取得视觉任务那令人惊叹的结果。这是为什么?这样的特征是否存在?或者,如果不存在,那么为什么视觉比语言更有利于这种形式的转移? 低级任务(如词性标签或分组)的输出可以被视为现场特征,但是这些特征不能捕获超越语法的更细粒度的语言使用规则,对所有任务都没有帮助。正如我们所看到的,可泛化的现场特征的存在似乎与一个可以被视为该领域许多任务的原型任务的存在相互交织在一起。在视觉任务中,对象识别占据了这样的地位。在NLP中,最接近的模拟可能是语言建模:给定一个词语序列,为了预测下一个单词或句子,模型需要掌握语言结构的知识,需要了解什么词语可能与之相关并且可能跟随出现,需要为长期依赖性建模等等。虽然最先进的语言模型越来越接近人类的水平,但它们的特征只被有限的使用了。同时,语言建模的进步也为其他任务带来了积极的成果:用语言模型对象预先训练模型提高了模型性能。此外,在一个大规模未标记语料库用近似语言建模对象预先训练的单词嵌入已经变得普遍。虽然它们不如视觉任务中的现场特征那样有效,但仍然有很大作用,可以看作是源自大规模未标记语料库的通用领域知识的一种简单形式的转移。 虽然在自然语言处理中,还没有通用的代理任务,但辅助任务可以采取本地代理的形式。无论是通过多任务对象还是综合任务对象,都可以将其他相关知识注入到模型中。 使用预先训练的特征是目前最直接和最常用的执行转移学习的方式。然而,它并不是唯一的办法。 学习的域不变表征 预先训练的特征实际上主要用于适应场景3,在此场景中我们希望其适应新的任务。在其他场景中,通过深度学习迁移知识的另一种方法是学习基于我们的域不会改变的表征。这种方法在概念上非常类似于我们一直在考虑使用的预先训练的CNN特征的方式:两者都将域的一般知识进行编码。然而,创建基于域不改变的表示对于非视觉任务来说,要比生成对所有任务有用的表征花费更低,更可行。ImageNet已经花费了数年和几千小时的时间,而我们通常只需要每个域的未标记数据来创建域不变的表征。这些表征通常使用堆叠去噪自动编码器学习,并且在自然语言处理以及计算机视觉方面已见成效。 使表征更相似 为了提高从源到目标域的学习表示的迁移能力,我们希望两个域之间的表征尽可能相似,以便该模型不考虑可能阻碍表征的特定于域的特征,而只考虑域之间的共性。 我们不仅仅是让自动编码器学习部分表征,而是积极促使两个域的表征更加相似。我们可以将其作为预处理步骤直接应用于我们的数据表征,然后将新的表征用于训练。我们还可以促使我们模型中域的表征更加相似。 容易混淆的域 为现有模型添加另一个目标,鼓励它混淆这两个领域,这是近来愈发常用的确保两个域的表征相似性的另一种方法。该域混淆的损失是一种规则的分类损失,模型在其中尝试预测输入示例的域。然而,与规则损失的差异在于,从损耗流向网络其余部分的梯度是相反的,如图16所示。

图16:具备梯度反转层的混淆域(Ganin和Lempitsky,2015) (责任编辑:本港台直播) |