|

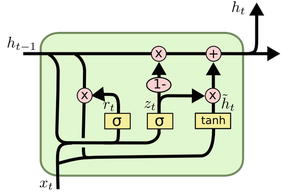

可以看到,标黑部分是较为不通顺的地方,但是通篇来看,谷歌翻译在正确性上已经让人印象非常深刻。基本上达到70%-80%的正确率。如果不是准确性要求非常严格的文本,在可用性上基本可以满足。 当然,演讲内容本身是比较正规的文本,翻译起来难度也会比其他形式的文本容易一些。 谷歌翻译技术原理解析 谷歌在去年9月推出了一个新的翻译模型,自那时起,这个项目有一些有趣的发展,这篇文章将尽可能简明地解释这个翻译系统。 早期版本的谷歌翻译使用基于短语的机器翻译(Phrase-based Machine Translation,PBMT)。PBMT 的做法是将输入的句子分成一系列单词或短语,然后单独翻译每个短语。这显然不是最佳的策略,因为它完全没有考虑整个句子的上下文。新的翻译模型使用称为Google神经机器翻译(Google Neural Machine Translation,GNMT)的模型,对传统版本的 NMT 模型进行了改进。让我们看看 GNMT 的工作原理: 编码器 在理解编码器之前,必须先了解 LSTM(长短期记忆人工神经网络)是什么。简单来说,它是一个具有一些记忆(memory)概念的神经网络。LSTM 通常用于“学习”时间序列(time-series)或时序数据(temporal data)中的模式。在给定的任何点,它接受最新的输入向量并使用(最新输入+之前看到的一些“上下文”)的组合产生预期输出:

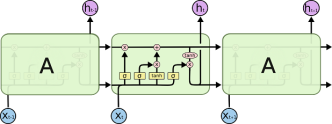

在上图中,x_t是在时间t上的输入,h_t-1 表示在t-1的上下文。如果x_t具有维度d,则维度2d的h_ t-1 是两个向量的串联: 1. 同一个 LSTM 在最后一个时间步长t-1(短期记忆)上的预期输出,以及 2. 另一个d维向量编码长期记忆——也称为单元状态(Cell State)。 第二部分通常不用于架构中的下一个组件。相反,atv,它被同一个 LSTM 用于以下步骤:通常通过向它们提供大量输入序列和期望的输出来训练 LSTM,这使得它们能够学习保留/保持输入的哪些部分,以及如何在数学上处理x_t和h_ t-1以得出h_t。 LSTM也可以“展开”(unfold),如下所示:

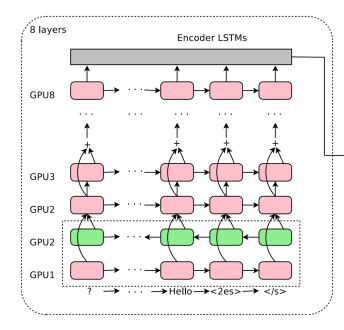

不用担心,它们是相同 LSTM 单元的一个副本(因此训练过程相同),每个单元将它们的输出馈送给下一个。这允许我们一次性输入整个输入向量的集合(也就是整个时间序列),而不用一步步通过 LSTM 的副本。 GNMT 的编码器网络本质上是一系列堆叠的 LSTM:

每个粉红色/绿色的框本身是一个展开的 LSTM,因此上图中每个序列有8个堆叠的 LSTM。整个架构的输入是句子的有序token集,每个token都以向量的形式表示。需要注意的是,这里说的是 token(语言符号),而非 word(单词)。GNMT 在预处理中将所有的词分解成了 tokens/pieces,然后作为序列馈入神经网络。这让框架(至少部分地)能够理解从未见过的复杂词。例如,“Pteromerhanophobia”这个词,即使你从没见过,你可能也能理解它大概是指一种“恐惧”,因为它含有“phobia”(恐惧症)这个 token。谷歌把这种方法称为 Wordpiece 建模(Wordpiece modeling)。在训练阶段,将词汇分解为 token 是基于统计学习的方法(哪个token组合最有意义)。 在堆叠(stack)LSTM 时,每层都会学习前面一层(下层)馈送到它的时间序列中的模式。随着阶梯越来越高,你会开到越来越多的数据中的抽象模式被馈送到最高层。例如,最低层可能看到一系列的点,并推导出一条线;下一层看到一些线,并推导出一个多边形;接下来的层看到一组多边形,并学习一个物体,等等。当然,堆叠的层数有一个限制,以什么方式堆叠 LSTM 也有限制——并不是层数越多越好,因为最终得到的模型可能太慢而难以训练。 除了 LSTM 的堆叠之外,上面所示的这种架构还有一些有趣的地方。

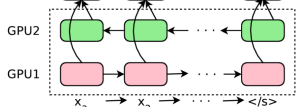

你会发现倒数第二层是绿色的。这是因为箭头(也即句子中token的顺序 [ordering])在这层中是相反的。这就意味着第二个 LSTM 看整句话时方向是反着的。原因很简单:当你把整个句子视为一个整体的时候,对于每个单词来说,“context”并不仅仅存在于它前面的单词里,同时也存在于它后面的那些单词里。最开始的两层都将原始句子视为输入,但是方向各不相同,彼此是相反的。第三层 LSTM 将从前面两层获得这种双向的输入——简单说,就是任何一个单词向前和向后的上下文语境。从这一层开始,每往后一层,神经网络都会学习到单词更加高层的模式。 (责任编辑:本港台直播) |