|

参与:微胖、曹瑞

虚拟现实能带来很赞的沉浸式体验,提供全新看待世界的方式,还能帮助我们探索新奇的环境,无论它是现实的抑或想象的。不过,与物理现实相比,与他人共享这些体验却很难,因为虚拟现实头盔很难让用户看清共享对方的完整面部。 混合现实(Mixed Reality)可以减轻一些不连贯,因为它可以在一个二维视频格式中实现 VR 用户虚拟文本的共享,其他用户可以感受到该用户的虚拟体验。即使混合现实能让共享变得容易,但是,头盔仍然盖住了面部表情和目光注视,这严重妨碍了完整的沉浸体验,也没办法在虚拟现实中看到整个人。 谷歌 Machine Perception 研究人员与 Daydream Labs 以及 Youtube Spaces 合作,j2直播,看看怎么解决这个问题,能否通过虚拟地「揭开」头盔,看到用户的脸,进而创造出一种现实般的看穿效果。

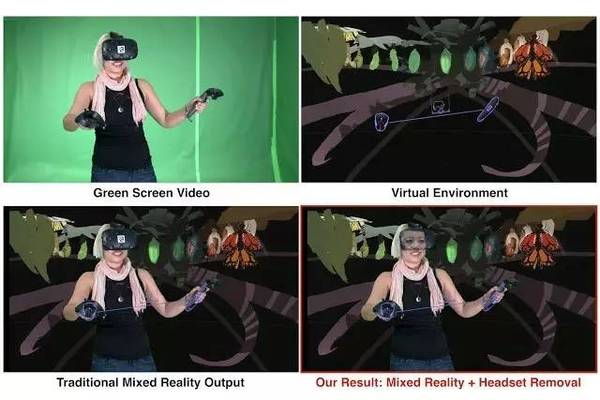

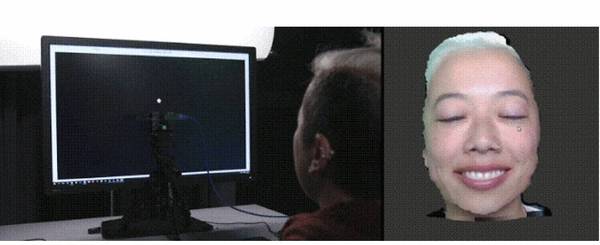

一个绿色屏幕前的虚拟现实用户与虚拟背景融合起来,生成一种混合现实:传统的混合现实输出会挡到用户面部,但是我们的输入会让你看到脸。注意,如何用标记修改头盔,方便追踪。 我们的办法结合了 3D 视觉、机器学习以及图形技术,最好在增强 MR 视频中加以说明(我们在 Google-VR blog 中也讨论过)。有三个部分: 动态面部模型捕捉 我们技术的核心思想是,将一个用户面部的 3D 模型作为被隐藏面部的代理。这个代理被用来合成 MR 视频中的面部,因此,可以创造摘掉头盔后的效果。首先,我们使用所谓的注视依赖动态外观(gaze-dependent daynamic appearance)技术,捕捉到一个用户的个性化 3D 面部模型。初次校准需要用户做在一个色彩+深度摄像头(a color+depth camera)和一个监视器前面,然后,眼睛追踪监视器上的标记。我们使用这种一次校准程序(one-time calibration procedure)——通常耗时不到一分钟——来获取用户的 3D 面部模型,还要学习一套将外观图像(或文理质地)映射到不同注视方向和眨眼状态上的数据集。这个目光注视数据集(gaze database)能让我们在合成任何想要的注视状态时,显著改善面部外观,让合成表情更加自然生动。

左边,当她用眼睛跟踪显示器上的标记时,摄像头捕捉到了用户面部。右边,我们展示了重新建构 3D 面部模型的动态性质:移动或点击鼠标,我们就能模拟注视和眨眼状态。 校准和对齐 创造混合现实视频需要一个专门的装备,包括一个外部摄像头,可校准并与头盔同步。这个摄像头用来捕捉绿色屏幕前虚拟现实用户的视频流,然后将用户剪影与虚拟世界混合起来,生成最终的混合虚拟现实视频。其中,很重要的一个环节就是准确估计测摄像头和头盔的对齐系统之间的校准(固定的 3D 转换,fixed 3D transformation)。这些校准技术通常包括显著的人工干扰,完成需要多个步骤。通过给头盔前端加上一个物理标记并在 3D 中进行虚拟跟踪,我们可以简化整个过程,因为这可以实现自动优化校准参数。 因为「摘掉」了头盔,所以,我们需要将 3D 面部模型和摄像头流中的面部可见部分对齐,实现无缝对接。这一对齐的合理代理就是将面部模型放到头盔后面。上面描述的校准,连同虚拟现实头盔跟踪,能提供充足的信息来决定如何放置,这样,我们就能通过提供虚拟面部,修改摄像头流(camera stream)。 合成和渲染 在处理完对齐之后,最后一步涉及到生成 3D 脸部模型适当渲染,要与摄像头流中的内容保持一致。通过将我们的动态注视数据库和 HTC Vive 头戴式设备结合,重现用户真正的眼睛注视(eye gaze),HTC Vive 的眼球追踪技术是由 SMI 公司提供。眼球追踪器产生的图像缺乏充分细节来直接再生被挡面部区域,但是,非常适合提供细致的注视信息。使用追踪器实时注视数据,我们合成了一个能够精确代表用户注意力和眨眼的面部代理。在运行过程中,会搜索预处理步骤时捕捉到的注视数据库,找寻最符合查询注视状态的面部图像,同时也兼顾了美学,例如时空光滑度(temporal smoothness)。另外,为了解决已获取的注视数据组与运行过程时面部之间的亮度变化不同,我们使用了色彩校正和羽化,让合成面部区域与其他面部区域匹配。 (责任编辑:本港台直播) |