|

我们提出一个新的编码器 - 解码器 - 重构器框架。具体来说,我们的方法建立在基于注意力机制的 NMT (Bahdanau, Cho, and Bengio 2015; Luong, Pham, and Manning 2015)之上,这个 NMT 将在后面的实验中作为基线。我们注意到,我们提出的方法一般情况下适用于其他任何类型的 NMT 结构,例如序列到序列模型(seq2seq模型)。如图2所示,该模型架构有两个部分组成: 标准的编码器 - 解码器,读取输入的句子并输出翻译结果,以及似然性分数。 增加一个重构器,从解码器读取隐藏状态的序列,并输出一个精确地重构输入句子的分数。 主要结果

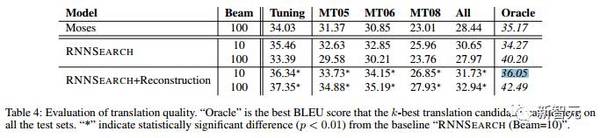

表4:对翻译质量的评估。 表4是在测试集上实验的翻译结果的 BLEU 分数。可以看到,RNNSEARCH 模型明显优于 Mose,BLEU 分高了2.2分,表明它是一个很强大的基线 NMT 系统。RNNSEARCH 模型引入了两种先进的技术。增加 beam 的大小以降低测试集上的翻译性能,这样就能与验证集上的结果一致。在下面的分析中,我们将我们的方法与“RNNSEARCH(Beam = 10)”进行比较,因为它在基线系统中有最佳性能。 首先,引入“重构”显著提高了模型性能,在 beam = 10 下新模型比基线模型的 BLEU 分数高 1.1。更重要的是,当扩大解码空间时,新模型的 BLEU 分数进一步提高了。第二,我们的方法在不同的 beam 大小上比基线系统有更好的翻译质量(见最后一列 Oracle 分数)。这证实了我们的想法,即组合的目标对为了产生更好的翻译结果进行参数训练有帮助。 结论 我们提出一个新的 NMT 框架,atv,即编码器 - 解码器 - 重构器框架,其中新增加的重构器引入辅助分数来测量译文的忠实度。我们提出的方法的有点有二:首先,它改进了参数训练以产生更好的翻译结果;第二,当解码空间增大时,它能够持续地提高翻译表现,而常规的 NMT 不能。实验结果表明,这两个优点确实能让基于这个方法的翻译提高质量。未来我们还需要验证我们的方法对更多语言和其他 NMT 架构的有效性。 相关论文: [1] Dzmitry Bahdanau, Kyunghyun Cho, and Yoshua Bengio. Neural Machine Translation by Jointly Learning to Align and Translate. ICLR 2015. [2] Sebastien Jean, Kyunghyun Cho, Roland Memisevic, and Yoshua Bengio. On Using Very Large Target Vocabulary for Neural Machine Translation. ACL 2015. [3] Minh-Thang Luong, Ilya Sutskever, Quoc V. Le, Oriol Vinyals, and Wojciech Zaremba. Addressing the Rare Word Problem in Neural Machine Translation. ACL 2015. [4] Minh-Thang Luong, Hieu Pham, and Christopher D Manning. Effective Approaches to Attention-based Neural Machine Translation. EMNLP 2015. [5] Shiqi Shen, Yong Cheng, Zhongjun He, Wei He, Hua Wu, Maosong Sun, and Yang Liu. Minimum Risk Training for Neural Machine Translation. ACL 2016. [6] Yong Cheng, Shiqi Shen, Zhongjun He, Wei He, Hua Wu, Maosong Sun, and Yang Liu. Agreement-based Joint Training for Bidirectional Attention-based Neural Machine Translation. IJCAI 2016. [7] Ilya Sutskever, Oriol Vinyals, and Quoc V. Le. Sequence to Sequence Learning with Neural Networks. NIPS 2014. [8] Yonghui Wu et al. Google’s Neural Machine Translation System: Bridging the Gap between Human and Machine Translation. arXiv 2016. [9] Shi Feng, Shujie Liu, Mu Li, and Ming Zhou. Implicit Distortion and Fertility Models for Attention-based Encoder-Decoder NMT Model. COLING 2016. [10] Wei He, Zhongjun He, Hua Wu, and Haifeng Wang. Improved Neural Machine Translation with SMT Features. AAAI 2016. [11] Zhaopeng Tu, Zhengdong Lu, Yang Liu, Xiaohua Liu, and Hang Li. Modeling Coverage for Neural Machine Translation. ACL 2016. [12] Zhaopeng Tu, Yang Liu, Zhengdong Lu, Xiaohua Liu, and Hang Li. Context Gates for Neural Machine Translation. TACL 2016. [13] Zhaopeng Tu, Yang Liu, Lifeng Shang, Xiaohua Liu, and Hang Li. Neural Machine Translation with Reconstruction. AAAI 2017. ,开奖 (责任编辑:本港台直播) |