|

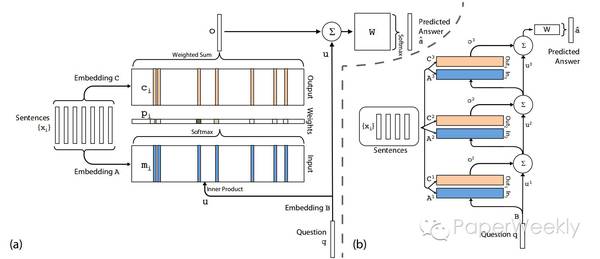

微信公众号:paperweekly 引言 Memory Networks是由Facebook的Jason Weston等人提出的一个神经网络框架,通过引入长期记忆组件(long-term memory component)来解决神经网络长程记忆困难的问题。在此框架基础上,发展出许多Memory Networks的变体模型,本期精选了5篇Memory Networks相关的论文,分别如下: 1、Memory Networks 2、End-To-End Memory Networks 3、Ask Me Anything: Dynamic Memory Networks for Natural Language Processing 4、THE GOLDILOCKS PRINCIPLE: READING CHILDREN’S BOOKS WITH EXPLICIT MEMORY REPRESENTATIONS 5、Key-Value Memory Networks for Directly Reading Documents Memory Networks作者 Jason Weston, Sumit Chopra, Antoine Bordes 单位 Facebook AI Research 关键词 Question Answering, Memory Network 文章来源 ICLR 2015 问题 为解决长期记忆问题, 提出一类称为Memory Networks的模型框架, 基于该框架构造的模型可以拥有长期(大量)和易于读写的记忆。 模型和思路 Memory Networks可以理解为一种构造模型的框架, 该类模型由如下五部分组成: 1、记忆m: 模型记忆的表示,由一个记忆槽列表[m1-mi]组成,可被G,O组件读写 2、组件I (input feature map): 将模型输入转化模型内部特征空间中特征表示 3、组件G (generalization): 在模型获取新输入时更新记忆m,可以理解为记忆存储 4、组件O (output feature map): 根据模型输入和记忆m输出对应于模型内部特征空间中特征表示,可以理解为读取记忆 5、组件R(response): 将O组件输出的内部特征空间的表示转化为特定格式,比如文本。可以理解为把读取到抽象的记忆转化为具象的表示。 假设模型输入为x: 记忆的更新过程表示为 mH(x) = G(mi, I(X), m), ?i, H(x)为选择记忆和遗忘机制 记忆的读取过程表示为 r = R(O(I(x), m)) 再次强调Memory Networks是一类模型框架, 组件I,G,R,O可以使用不同的实现 资源 facebook MemNN实现 简评文章提出了一个通用的解决长期记忆问题的算法框架, 框架中的每一个模块都可以变更成新的实现, 可以根据不同的应用场景进行适配。 End-To-End Memory Networks作者 Sainbayar Sukhbaatar, Arthur Szlam, Jason Weston, Rob Fergus 单位 Dept. of Computer Science Courant Institute, New York University Facebook AI Research 关键词 Memory Networks, End-to-end, Question Answer 文章来源 NIPS 2015 问题 本文提出了一个可以端到端训练的Memory Networks,并且在训练阶段比原始的Memory Networks需要更少的监督信息。 模型 本文提出的模型包括单层和多层两种情况。下面先介绍单层情况。 1、单层 如图(a)所示,输入的序列可以通过不同的Embedding矩阵A和C分别被表示成Input和Output向量的集合。同样的,通过Embedding矩阵B,我们将Question表示成一个向量u,向量u和Input向量集合中的每个向量计算内积,然后通过softmax得到一个概率向量p(attention过程),概率向量p中的每一个概率值表示每个Output向量对应输出的权重大小。通过p和Output向量集合,对Output中的向量进行加权求和得到输出向量o,将输出向量o和问题向量u相加,atv,再最后通过一个权值矩阵W和softmax来预测最终的label。

2、 多层 多层的情况如图(b)所示,每层的输出向量oi和问题向量ui相加获得新的问题表示ui+1,然后重复上述单层的过程,直到最后一层通过softmax来预测label。 本文在bAbi数据集、Penn Treebank以及Text8三个数据集上进行实验,均取得了较好的实验效果。 资源 [bAbi] (https://research.facebook.com/research/babi/) 简评 (责任编辑:本港台直播) |